Présenté par : Johnny Tomasiello

Biographie

Résumé :

Deriving Synchrony : A Real Time Interactive Brainwave-to-Music Translation Performance System est une œuvre immersive dont le but est d'explorer la relation réciproque entre l'activité électrique du cerveau et les stimuli externes qui ont été générés et définis par ces mêmes événements physiologiques, grâce à l'utilisation d'une interface cerveau-ordinateur-musique (BCMI) qui permet la sonification des données capturées par un électroencéphalogramme, qui sont traduites en stimuli musicaux en temps réel.

Il s'agit d'un système interactif de composition assistée par ordinateur qui traduit l'activité électrique du cerveau en compositions musicales en temps réel, tout en permettant à l'utilisateur d'exercer un contrôle conscient sur ce processus de traduction et sur la production sonore générative qui en résulte dans un cadre musical. Il peut également enseigner aux participants comment modifier positivement leur propre physiologie en apprenant à influencer les fonctions du système nerveux autonome par le biais d'un retour d'information neurologique et bidirectionnel.

Introduction :

Les données de l'EEG sur les ondes cérébrales ont permis de classer avec succès les états mentaux [1], qui affectent la "modulation autonome du système cardio-vasculaire" [2], et il existe des études sur la façon dont la musique peut influencer une réponse du système nerveux autonome [3]. [C'est en ayant ces phénomènes à l'esprit que ce travail a été conçu et développé.

Les changements dans la zone alpha sont l'objet principal de ce projet, puisque la recherche a montré que la stimulation de l'activité dans la zone alpha entraîne une relaxation musculaire, une réduction de la douleur, une régulation du rythme respiratoire et une diminution de la fréquence cardiaque [4] [5] [6]. [Il a également été utilisé pour réduire le stress, l'anxiété et la dépression, et peut favoriser l'amélioration de la mémoire et des performances mentales, et contribuer au traitement des lésions cérébrales.

Mes recherches précédentes sur ce sujet ont mis l'accent sur l'exploration et la quantification des effets neurologiques de la modulation des ondes cérébrales et des processus physiologiques correspondants par le biais d'un feedback neuro- et bidirectionnel comme forme de thérapie et d'entraînement aux ondes alpha, où la musique générative sert de système de neurofeedback en temps réel qui se comporte de manière à encourager des réponses optimales des ondes cérébrales, en particulier dans la zone alpha.

J'ai mis à profit mon expérience dans cette recherche et les données que j'ai recueillies pour proposer cette nouvelle itération. Ce système actuel permet à l'utilisateur un contrôle plus actif de la performance et de la musicalité du feedback génératif, résultant en un système de composition et de performance dont le comportement est défini de manière plus littérale par les intentions de l'utilisateur, tout en continuant à fonctionner comme un système de neurofeedback réciproque.

Ce qui est exploré ici est donc élargi pour inclure la manière dont l'ajout du comportement orienté vers un but d'un paradigme de changement de tâche affecte la flexibilité cognitive [7], et la quantité de traitement simultané conscient nécessaire pour qu'un sujet affecte le feedback musical qui en résulte. Cette dimension supplémentaire prend en compte les calculs neuronaux qui déterminent comment les neurones prennent des décisions d'allumage, ce qui détermine directement l'activité des ondes cérébrales qui est mesurée.

La procédure, lors de l'utilisation de ce travail pour l'exploration des effets physiologiques du feedback neuro- et bidirectionnel, commence par l'obtention et la comparaison de deux ensembles de données : un ensemble de contrôle et un ensemble thérapeutique. L'ensemble de contrôle suit les données EEG sans utiliser le feedback musical, tandis que l'ensemble thérapeutique enregistre les données avec le feedback.

La méthodologie de recherche explore la manière de collecter et de quantifier les données physiologiques par le biais de la neuro-imagerie non invasive, en utilisant efficacement les ondes cérébrales du sujet pour produire des compositions et des paysages sonores interactifs en temps réel qui, expérimentés simultanément par le sujet, ont la capacité d'altérer ses réponses physiologiques.

Le contenu mélodique et rythmique est dérivé et constamment influencé par les relevés EEG du sujet. Un sujet qui se concentre sur le retour d'information qui en résulte peut tenter de provoquer un changement dans ses systèmes physiologiques, avec le double objectif d'affecter directement la performance musicale et d'obtenir une réponse optimale en alpha.

Les réponses physiologiques qui en résultent sont enregistrées et mesurées afin de déterminer l'efficacité de l'utilisation de stimuli externes pour affecter le corps humain sur les plans physiologique et psychologique.

Outre l'étude de ces questions neuroscientifiques, ce projet vise à explorer la validité de l'utilisation de la méthode scientifique dans le cadre d'un processus artistique. La méthodologie consistera à créer un système basé sur des preuves afin de développer des projets basés sur la recherche.

Comme l'a dit Gita Sarabhai à John Cage, "la musique conditionne l'esprit, ce qui conduit à des moments de la vie qui sont complets et comblés" [8]. [8]. Dans ce cas, la musique peut également être utilisée par l'esprit pour conditionner le corps.

Informations sur l'EEG :

Un électroencéphalogramme (également appelé EEG) est une méthode de surveillance électrophysiologique utilisée pour enregistrer l'activité électrique du cerveau. Le signal EEG typique d'un adulte humain se situe entre 10 et 100 µV (microvolts) d'amplitude lorsqu'il est mesuré sur le cuir chevelu. L'EEG a été inventé par le psychiatre allemand Hans Berger en 1929 et les recherches sur l'interprétation et la modulation des ondes cérébrales ont commencé peu de temps après. L'EEG permet de mesurer directement l'activité neuronale et de saisir les processus cognitifs en temps réel. Berger a prouvé que les ondes alpha (également connues sous le nom d'ondes de Berger) étaient générées par les neurones du cortex cérébral.

En 1934, les physiologistes anglais Edgar Adrian et Brain Matthews ont décrit pour la première fois la sonification des ondes alpha dérivées des données EEG[9]. [Ils ont constaté que "les activités non visuelles qui exigent toute l'attention (par exemple le calcul mental) abolissent les ondes ; les stimulations sensorielles qui exigent de l'attention le font également" [10], ce qui montre comment la concentration et les processus de pensée affectent l'activité dans la gamme de fréquences des ondes alpha.

L'activité cérébrale enregistrée dans un EEG est la somme des potentiels post-synaptiques inhibiteurs et excitateurs qui se produisent à travers une membrane neuronale[11]. [11]

Les mesures sont effectuées à l'aide d'électrodes placées sur le cuir chevelu. Les mesures sont divisées en cinq bandes de fréquence, délimitant les ondes lentes, modérées et rapides. Les bandes, de la plus lente à la plus rapide, sont les suivantes :

Delta, avec une gamme d'environ 1,0Hz-4,0Hz, qui signifie la méditation la plus profonde ou le sommeil sans rêve.

Thêta, d'environ 4 Hz à 8 Hz, signifiant la méditation ou le sommeil profond.

Alpha, d'environ 7,5 Hz à 13 Hz, représentant des pensées qui s'écoulent tranquillement.

Bêta, d'environ 13 Hz à 30 Hz, qui correspond à un état d'éveil normal.

Et

Gamma, d'environ 30 Hz à 44 Hz, qui est le plus actif pendant le traitement simultané d'informations qui mobilisent plusieurs zones différentes du cerveau.

Histoire de l'utilisation de l'EEG dans la musique :

Le physicien Edmond Dewan a commencé à étudier les ondes cérébrales au début des années 1960 et a mis au point un "système de controle des ondes cérébrales". Ce système détectait les changements dans les rythmes alpha et permettait d'allumer ou d'éteindre l'éclairage. La lumière pouvait également être remplacée par "un dispositif sonore qui émettait un bip lorsqu'il était allumé", ce qui permettait à Dewan d'épeler la phrase "JE peux parler" en mode Morse [9]. [Par la suite, Dewan a rencontré le compositeur expérimental Alvin Lucier, ce qui lui a inspiré la première composition sur les ondes cérébrales.

Alvin Lucier a créé Music for Solo Performer en 1965. Le compositeur était assis sur une chaise sur scène, les yeux fermés, et ses ondes cérébrales étaient enregistrées. Les données de l'enregistrement étaient amplifiées et distribuées à des hauts)parleurs étaient placés contre différents types d'instruments de percussion, de sorte que la vibration des hauts-parleurs provoquait le son de l'instrument.

Lucier a pu contrôler les événements de percussion en maîtrisant ses fonctions cognitives, et a constaté qu'une interruption de la concentration perturbait ce contrôle. Bien que la maîtrise du rythme alpha ait été (et soit toujours) difficile, Music for Solo Performer a grandement contribué au domaine de la musique expérimentale et a illustré la profondeur des possibilités d'utilisation du contrôle de l'EEG sur la performance musicale.

L'informaticien Jacques J. Vidal a publié en 1973 l'article Toward Direct Brain-Computer Communication, qui proposait pour la première fois l'interface cerveau-ordinateur (ICCO), c'est-à-dire un moyen d'utiliser le cerveau pour contrôler des appareils externes.

Ce fut le tout début de la recherche sur l'interface cerveau-ordinateur-musique (BCMI), qui a évolué pour devenir un domaine d'étude interdisciplinaire "au carrefour de la musique, de la science et de l'ingénierie biomédicale" [12]. Les BCMI (également appelées interfaces cerveau-machine ou IMC) sont encore utilisées aujourd'hui, et le domaine de recherche qui les entoure n'en est qu'à ses débuts.

Paul Lehrer, sous la direction duquel j'ai étudié à l'UMDNJ, a contribué de manière significative à la recherche dans le domaine de la psychophysique entre les années 1990 et aujourd'hui, avec des études sur le biofeedback et les techniques de gestion du stress. Le DR Lehrer a également établi des normes pour les thérapies musicales et leur utilisation en tant que techniques de relaxation et leurs effets physiologiques bénéfiques en testant les avantages chez les sujets souffrant d'asthme. L'un de ses récents articles de recherche datant de 2014, intitulé Heart Rate Variability Biofeedback : How and Why Does it Work ? [14] a étudié l'efficacité du biofeedback de la variabilité de la fréquence cardiaque (HRVB) en tant que traitement pour une variété de troubles, ainsi que son utilisation pour l'amélioration des performances.

Aperçu du projet :

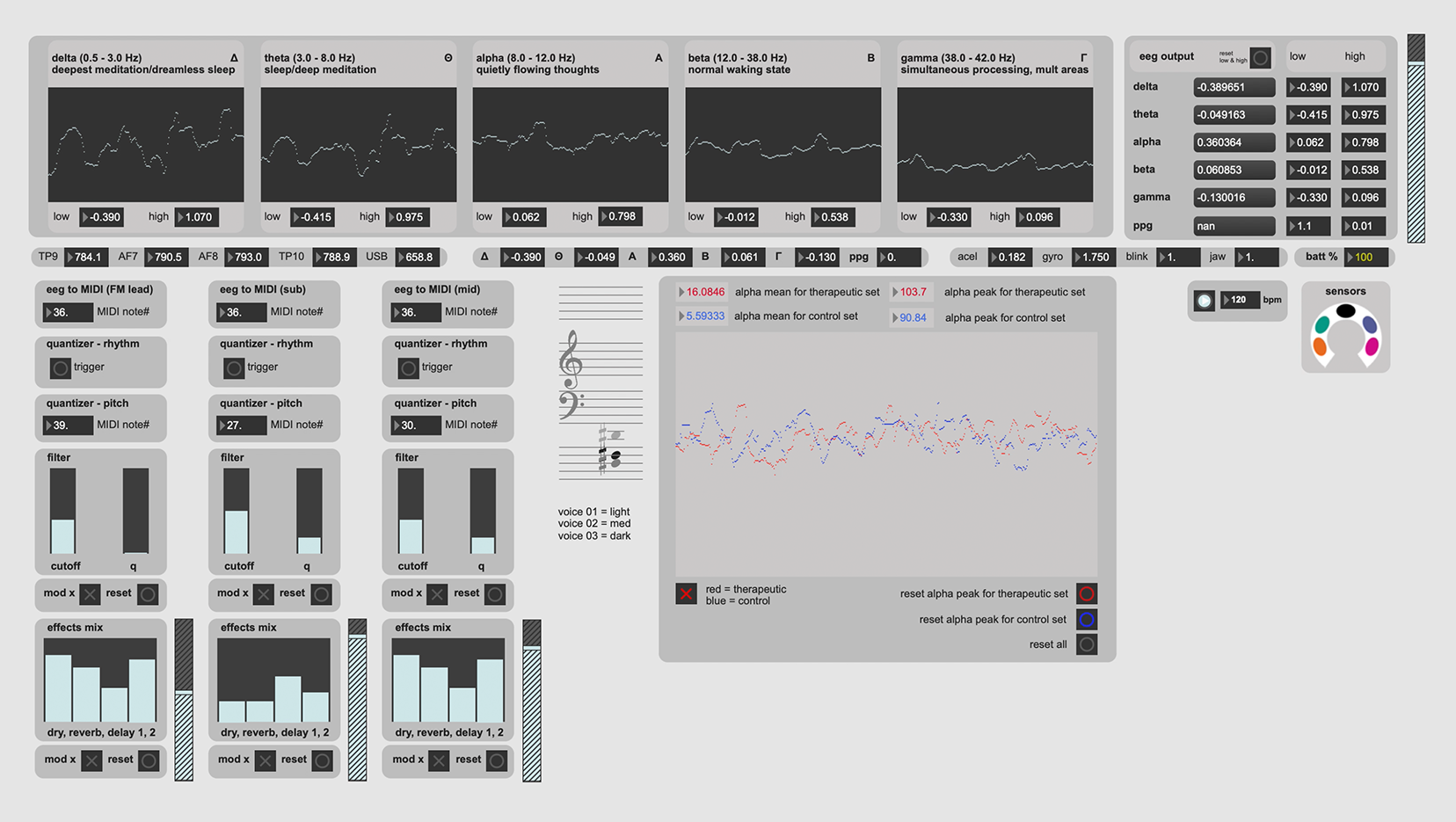

Ce projet enregistre les signaux EEG d'un sujet à l'aide de quatre électrodes extra-crâniennes sèches non invasives d'un bandeau EEG MUSE disponible dans le commerce. Les mesures sont enregistrées à partir des électrodes TP9, AF7, AF8 et TP10, comme spécifié par le système de placement EEG standard international, et les données sont converties en puissances de bande absolues, sur la base du logarithme de la densité spectrale de puissance (DSP) des données EEG pour chaque canal. Les données relatives à la fréquence cardiaque sont obtenues par des mesures PPG. Les mesures EEG sont enregistrées en Bels/Db pour déterminer la DSP dans chacune des gammes de fréquences.

Les relevés EEG sont traduits en musique en temps réel. La base temporelle des événements musicaux peut être variable (et/ou basée sur les données des ondes cérébrales), ou contrainte par une horloge régulière. Le choix des gammes, des modes et des accords utilisés, ainsi que les rythmes et les caractéristiques de la performance, doivent être soigneusement étudiés au préalable afin que l'extraction d'un ensemble fini de paramètres de l'ensemble des données EEG puisse être analysée et utilisée pour produire un morceau de musique dynamique et bien formé.

Ce système comporte trois sections principales :

1: La section de capture des données EEG.

2: La section de conversion des données EEG.

3: La section Génération de sons et DSP.

La (1) section de capture des données EEG reçoit les données EEG du casque Muse, qui sont converties en données OSC et transmises par WiFi via l'application iOS Mind Monitor. Ces données sont ensuite divisées en cinq bandes de fréquences d'ondes cérébrales distinctes : delta, thêta, alpha, bêta et gamma. D'autres données sont également saisies, notamment celles de l'accéléromètre, du gyroscope, du clignement des yeux et de la crispation de la mâchoire, afin de contrôler tout artefact dans la saisie des données. Les données de connexion du capteur sont utilisées pour visualiser l'intégrité de la fixation du capteur au sujet. Les données PPG sont également saisies pour être utilisées dans une future itération du projet.

La (2) section de conversion des données EEG accepte les données de la bande passante EEG représentant des potentiels liés à des événements spécifiques, qui sont ensuite traduits en événements musicaux.

Cette section est composée de trois sous-sections qui formatent leurs données de sortie différemment, selon le cas d'utilisation :

1. Génération interne de sons et DSP

Il est destiné à être utilisé entièrement dans l'environnement Max, où la capture de données est convertie en événements musicaux et sonifiée à l'aide d'une synthèse et d'effets construits directement dans Max.

2. MIDI externe

Il est utilisé avec du matériel ou des logiciels équipés d'un système MIDI,

and

3. Fréquence externe et gate, pour utilisation avec des synthétiseurs modulaires.

Chacun de ces éléments peut être utilisé séparément ou simultanément, en fonction des besoins de la pièce.

Tout d'abord, les limites supérieures et inférieures des relevés d'ondes cérébrales sont relevées à des fins d'étalonnage, et des seuils significatifs sont définis pour chaque largeur de bande de fréquence d'ondes cérébrales. Ces seuils sont choisis sur la base des mesures EEG moyennes et optimales effectuées avant la génération du feedback musical. Lorsque ces seuils sont atteints ou dépassés, un événement est déclenché. En fonction des mappages, ces événements peuvent être un ou plusieurs types d'opérations : le son d'une note, un changement de hauteur, de gamme ou de mode, des valeurs et des temps de notes, et/ou d'autres caractéristiques de performance génératives, telles qu'un changement de timbre.

Pour la conversion des données, les potentiels liés à l'événement sont cartographiés de la manière suivante :

Les variations de l'alpha, par rapport au seuil prédéfini, régissent la hauteur du son.

Les changements de thêta, par rapport au seuil, influencent la synchronisation et le rythme des notes, ainsi que le déclenchement des notes/la densité des notes (par rapport aux valeurs de bêta).

Les changements de bêta, par rapport au seuil, influencent l'échelle et la transposition.

Les variations du delta, par rapport au seuil, influencent les qualités spatiales telles que la réverbération et le retard.

Les changements de gamma par rapport au seuil influencent le timbre.

Chacun de ces mappages ou de ces seuils peut être facilement modifié pour s'adapter à une autre thèse ou à un autre ensemble de normes.

La troisième section est (3) Génération de sons et DSP. It is responsible for the sonification of the data translated from the EEG data conversion section. This section includes synthesis models, timbral characteristics, and spatial effects.

La version Génération de sons internes et DSP de ce projet utilise trois voix de synthèse créées dans Max pour le feedback musical génératif. Il y a deux voix soustractives qui utilisent chacune un mélange d'ondes sinusoïdales, de dents de scie et d'ondes triangulaires, et une voix fm.

Les effets timbriques utilisés sont le mélange de formes d'ondes, la modulation de fréquence et les filtres passe-haut, passe-bande et passe-bas. Les effets spatiaux utilisés sont la réverbération et le retard. Outre les réglages initiaux des voix, chacun des effets timbriques et spatiaux est modulé par des données distinctes de potentiel lié à l'événement capturées par l'EEG.

Conclusions :

Ce projet est une interprétation contemporaine d'une idée qui m'intéresse depuis de nombreuses années et qui a commencé par des recherches sur le biofeedback EKG bidirectionnel.

J'ai commencé par étudier le biofeedback bidirectionnel de l'électrocardiogramme. Ma première expérience en la matière a eu lieu lors d'un diplôme universitaire en psychophysique à l'université Rutgers (financé par l'université de médecine et de dentisterie du New Jersey). À l'UMDNJ, j'ai eu le privilège de travailler directement avec certains des médecins qui étaient à la pointe de la recherche psychophysiologique et dont les travaux visaient à réduire le stress chez les sujets asthmatiques afin de diminuer la fréquence des crises[13].

À l'époque, la technologie nécessaire pour explorer cette idée était d'une taille considérable et d'un coût prohibitif, sauf à des fins médicales ou académiques officiellement financées. Avec la disponibilité actuelle d'appareils d'électroencéphalographie (EEG) et de moniteurs de fréquence cardiaque bon marché, la possibilité d'explorer ces concepts de manière autonome est devenue une réalité.

Bien que ce projet s'intéresse principalement aux changements dans la gamme de fréquences des ondes cérébrales alpha de l'EEG, des changements dans d'autres gammes de fréquences sont utilisés pour déclencher des événements dans le feedback. Cette approche a été adoptée pour garantir que la perte de concentration d'un sujet (et/ou une baisse de la densité spectrale de puissance de l'alpha) n'affecte pas négativement la génération d'un nouveau feedback musical. Avec l'aide d'un feedback cohérent, le sujet serait capable de se concentrer à nouveau et de continuer. En fonction de l'état de relaxation du sujet (et de la DSP des quatre autres gammes de fréquences EEG mesurées), la performance et le phrasé du feedback musical changeront de manière à encourager une plus grande concentration.

Pour les premiers essais de validation du concept, j'ai testé un petit échantillon de sujets. Les données préliminaires montrent que les lectures alpha étaient plus élevées, en moyenne, pendant la phase thérapeutique. De même, la valeur maximale globale a été plus élevée pendant la phase thérapeutique. Cela suggère que ce modèle de rétroaction est un moyen efficace d'augmenter l'activité dans la gamme de fréquences des ondes cérébrales alpha, ce qui est l'effet physiologique et psychologique bénéfique que j'espérais trouver, bien que beaucoup plus de données doivent être collectées avant que des conclusions définitives puissent être tirées.

La conception modulaire du travail permet d'inclure ou d'exclure presque n'importe quelle variable, ce qui sera nécessaire pour faire avancer la recherche, afin de tester plus en profondeur les éléments fondamentaux de la thèse, ainsi que toute exploration et analyse musicologique que la définition de la rétroaction soulève.

Entre-temps, outre la recherche et la collecte de données, j'utilise le logiciel comme système de composition pour créer des œuvres enregistrées et des bandes sonores en direct. Je prévois également de monter le projet sous la forme d'une installation interactive en direct.

Coordonnées du contact :

Johnny Tomasiello

https://johnnytomasiello.com/

Crédits et remerciements :

IRCAM

Cycling ’74

Dr. Paul M. Lehrer and Dr. Richard Carr

InteraXon Muse electroencephalography headband

James Clutterbuck (Mind Monitor developer)

Carol Parkinson, Executive Director of Harvestworks

Melody Loveless, NYU & Max certified trainer

Références :

[1] J. J. Bird, A. Ekart, C. D. Buckingham, D. R. Faria. “Mental Emotional Sentiment Classification with an EEG-based Brain-Machine Interface”, International Conference on Digital Image & Signal Processing (DISP’19), Oxford, UK (2019)

[2] K. Madden and G.K. Savard. “Effects of Mental State on Heart Rate and Blood Pressure Variability in Men and Women” in Clinical Physiology 15, 557–569 (1995)

https://pubmed.ncbi.nlm.nih.gov/8590551/

[3] F. Riganello et al. “How Can Music Influence the Autonomic Nervous System Response in Patients with Severe Disorder of Consciousness?” in Frontiers in Neuroscience vol. 9, 461 (2015)

[4] H. Marzbani et al. “Methodological Note: Neurofeedback: A Comprehensive Review on System Design, Methodology and Clinical Applications” in Basic and Clinical Neuroscience Journal vol. 7, 143–158 (2016)

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC4892319/

[5] P.M. Lehrer and R. Carr “Stress Management Techniques: Are They All Equivalent, or Do They Have Specific Effects?” in Biofeedback and Self-Regulation” (1994)

https://pubmed.ncbi.nlm.nih.gov/7880911/

[6] J. Ehrhart, M. Toussaint, C. Simon, C. Gronfier, R. Luthringer, G. Brandenberger. “Alpha Activity and Cardiac Correlates: Three Types of Relationships During Nocturnal Sleep” in Clinical Neurophysiology vol. 111, 940–946 (2000)

https://pubmed.ncbi.nlm.nih.gov/10802467/

[7] Amy L. Proskovec, Alex I. Wiesman, and Tony W. Wilson. “The Strength of Alpha and Gamma Oscillations Predicts Behavioral Switch Costs”, Neuroimage, 274–281 (2019 Mar; 188)

https://www.ncbi.nlm.nih.gov/pmc/articles/PMC6401274/

[8] J. Cage, R. Kostelanetz. John Cage Writer: Previously Uncollected Pieces.

New York: Limelight (1993)

[9] B. Lutters, P. J. Koehler. “Brainwaves in Concert: the 20th Century Sonification of the Electroencephalogram” in Brain 139 (Pt 10), 2809–2814 (2016)

https://academic.oup.com/brain/article/139/10/2809/2196694#

[10] A Matthews, “The Berger Rhythm: Potential Changes From The Occipital Lobes in Man” in Brain 57 Issue 4, (December 1934)

https://academic.oup.com/brain/article/133/1/3/314887

[11] M Atkinson, MD, “How To Interpret an EEG and its Report” (2010)

https://neurology.med.wayne.edu/pdfs/how_to_interpret_and_eeg_and_its_report.pdf

[12] E.R. Miranda. “Brain–Computer Music Interfacing: Interdisciplinary Research at the Crossroads of Music, Science and Biomedical Engineering” in E.R. Miranda, J. Castet, ed. Guide to Brain-Computer Music Interfacing. London: Springer-Verlag, 1–27 (2014)

[13] P.M. Lehrer et al. “Relaxation and Music Therapies for Asthma among Patients Prestabilized on Asthma Medication” in Journal of Behavioral Medicine 17, 1–24 (1994)

https://pubmed.ncbi.nlm.nih.gov/8201609/

[14] [10] P. M. Lehrer, R. Gevirtz. “Heart Rate Variability Biofeedback: How and Why Does It Work?” in Frontiers in Psychology vol. 5, 756 (2014)